Bem galera, neste post, explicarei um pouco mais sobre o hardware, utilizando meu computador como referência. A princípio falarei da Motherboard ou como queira,

Placa mãe. Ela é uma

ASUS M2N-SLI e vocês podem fazer o download do manual neste

link.

A

placa mãe é um dos componentes mais importantes em um computador, tanto que todos os outros, se comunicam utilizando a placa mãe como canal e é por isso que todos os equipamentos tem que ser encaixados na nela. Mas, a placa mãe tem vários micro componentes, são esses os responsáveis por tal comportamento.

Falando em placa mãe, ouvimos muito falar de um tal de “SOCKET”, e vemos também que essa nomenclatura é utiliza nos processadores, e por quê?

Quando falamos de socket, nos referimos a um encaixe utilizado pela placa mãe para receber processadores. Esses sockets permitem a comunicação entre a placa mãe e o processador. E como vou saber se um socket de processador é compatível com uma placa mãe? Geralmente destingimos os sockets pela quantia de pinos que eles tem, processadores de sockets mais atuais como 939/940 e o AM2/AM2+ são exemplos dessa nomenclatura. Para entender melhor, os números são usados pelos processadores da INTEL, e os “nomes” são utilizados pela AMD, que não fazem questão de dizer quantos pinos tem, e até porque eles podem ter a mesma quantidade de pinos mas trabalham de forma diferente, então eles decidiram trabalhar com nomenclatura, ao contrário da Intel, que trabalha com números.

Então, quando for comprar uma placa mãe, para um processador X, você tem que estar certo de que um serve para o outro. No meu caso, placa mãe que é uma ASUS M2n-SLI como citei acima, trabalha com padrão AM2, e meu processador que é um Athlon 64 x2 5200+, o socket deste processador também é AM2 logo, a placa mãe e o processador são compatíveis.

Na placa mãe, temos outras coisas importantes para saber, por exemplo, o tipo de memória primária que a placa mãe aceita.

No que tange a Memória primária, existem vários padrões, os mais atuais são DIM(bem obsoleta já), DDR1(ou simplesmente DDR), DDR2(evolução do DDR1, mais barata e de melhor qualidade) e DDR3(entrando no mercado agora, bem rápidas porém bastante caras). Na hora que você for comprar memória para sua placa mãe, você precisa verificar qual desses modelos sua placa mãe recebe para não errar na hora da compra. Minha placa mãe aceita DDR2, e tem 4 slots para as memórias, para melhor desempenho, deve-se colocar números pares de memórias(2 memórias ou 4), explanarei futuramente o porquê.

A placa mãe também recebe encaixe de memórias secundárias que a princípio podem ser concebidas como o HARD DISK(HD). Para HD temos 3 padrões bem populares, IDE(bem obsoleto), SATA(está aos poucos deixando o mercado) e SATA II(entrando no mercado a toda força). Você tem que verificar antes de comprar memória secundária para sua placa mãe, qual é o modelo que ela recebe. Hoje em dia é comum pegar placas mães que recebem múltiplos tipos de memória secundária, existem umas que recebem de IDE à SATA II. Podem ser incluídas na categoria da memória secundária, drivers de CDs, DVDs, Disquetes ou todos aqueles componentes da placa mãe que se comunicarem com a mesma via uma dessas 3 tecnologias que citei acima. Minha placa mãe aceita SATA e SATA II. Os Drivers de CDs, DVDs e Disquetes, podem ser chamados de Dispositivos de Entrada.

Outro componente que podemos inserir na placa mãe é a placa de vídeo, mas muitas placa mães já possuem uma placa de vídeo básica interna, essa chamamos de ONBOARD(embarcado) e para as placa mães que não vem com placa de vídeo, chamamos de OFFBOARD(desembarcada), para as placa mães que possuem placa de vídeo onboard, é opcional comprar uma placa de vídeo extra, para as placas mãe com placa de vídeo offboard é obrigação comprar uma placa de vídeo, visto que essa não possue nenhum dispositivo interno de vídeo. Existem várias informações em volta da placa de vídeo, mas guardarei uma seção só para falar dela. A placa de vídeo pode ser acoplado em encaixes do tipo AGP x4(bem obsoleto), AGP x8(deixando o mercado aos poucos) e PCI-EX 16x(entrando no mercado) ou PCI-EX 32x(extremamente poderosa, podendo utilizar aplicações gráficas com os maiores níveis de desempenho, também vale citar que são caras), hoje em dia o mais utilizado é o PCI-EX 16x, que é o meu caso, só que minha placa mãe tem uma caraterística especial, chamada SLI, essa feature, permite que eu bote 2 placas de vídeos, para cada uma existe um encaixe PCI-EX 16x, e posso fazer com que as duas trabalhem simultaneamente, aumentando potencialmente a força de trabalho das placas. Esse equipamento está classificado como Dispositivos de Saída. Minha placa de vídeo é uma

GEFORCE 9600GT.

A placa mãe possui um barramento importante chamado

FSB(Front Side Bus), essa FSB é responsável pela comunicação que existe entre o processador e a memória primária, em placa mães antigas, a FSB é apenas 2 barramentos de comunicação com a memória, um para ida e outro para a volta dos dados. Nas placas mães atuais a FSB geralmente são quatro barramentos, dois de ida e dois de volta, assim, a placa mãe consegue o dobro de processamento, desde que você tenha números pares de memórias instaladas em seu computador, pois só assim os dois barramentos são ativos. A idéia do barramento duplo surgiu junto com o mundo dos processadores de duplo núcleo, estávamos conseguindo um numero alto de processamento, pelo contrário, não adiantava tanto processamento se não conseguíamos acessar a memória a uma velocidade suficiente para que as operações valessem a pena, então, resolveram criar o barramento duplo da FSB, atualmente existem projetos sobre o barramento quádruplo e irão conseguir altos níveis de processamento. Minha placa mãe identifica meu FSB como 2000mhz HyperTransport.

Isso significa, que os dois caminhos de ida e os dois caminhos de volta, tem um total de 2000mhz de freqüência de comunicação, um numero razoável para computador pessoal.

Mais informações sobre a tecnologia

HyperTransport que é própria da AMD, você pode achar neste

link.

Outro componente importante da placa mãe é o

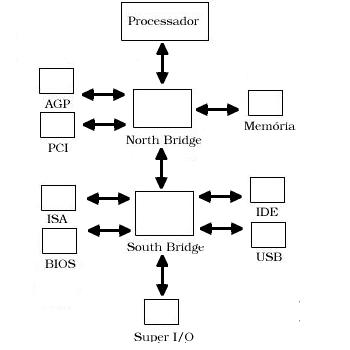

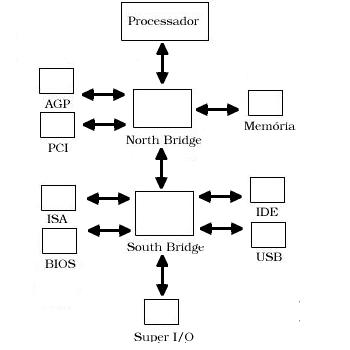

CHIPSET, irei explicar detalhadamente o que é e para que serve agora. Vejam a foto do chipset.

Em base, o chipset é um dos componentes mais importantes no computador, visto que ele que controla os componentes da placa mãe, ele faz controle dos BARRAMENTOS PCI, BARRAMENTOS AGP, controle do acesso a memória, controle dos IRQ(Interrupt Request) e DMA(Direct Memory Access, ou acesso direto de memória), controle da interface IDE e USB.

Vejam um esquema rápido de como o CHIPSET NORTE E SUL controla tudo:

Notem que ISA é um controlador bem antigo e obsoleto por isso não comentei sobre. Super I/O é um bloco lógico que trabalha com o Input/Output, que significa Entrada e saída.

A placa mãe geralmente tem portas PCI de 2x, 4x e 8x, extras, para o caso de você queira acoplar dispositivos extras, tais como modem dial-up, placa de rede wireless ou placa de rede de cabo, ou até mesmo uma placa de som, mas placa de som, quase toda placa mãe possui ONBOARD.

Ufa, acho que acabei os comentários sobre placa mãe.

Irei falar de algo light que é pra poder relaxar a mente, vou falar das memórias.

Elas podem ser primárias ou secundárias, e servem exclusivamente para gravar dados resultados de processos.

A memória primária podem ser chamadas de MEMORIA RAM, e tem principais modelos,

DIMM,

DDR e

DDR2 como eu disse já acima, e a melhor atualmente no mercado é a DDR2, pois tem um ótimo “custo x beneficio”, mas existem 3 fatores importantes numa memória, o primeiro é o tamanho do BUFFER, ou seja, a quantia de dados que a memória pode guardar, geralmente esse dado é potência de 2, assim, o tamanho do buffer podem ser, 2mb,4mb,8mb,16mb,32mb,...,512mb,1gb,2gb,4gb e assim por diante, sendo que os quatro últimos valores que eu passei são os mais comuns no mercado, os de antes já são obsoletos. O segundo fator importante na memória, é a freqüência de comunicação, que é determinada em MHz, e nas memórias DDR são comuns 200mhz a 400mhz, já as memória DDR2 vão de 400mhz à 800mhz.

Vale lembrar que

DDR significa

Double Data Rating, pois esse modelo, consegue um valor de trabalho maior do que o seu modelo anterior

DIMM.

O terceiro fator é a

latência, conhecia vulgarmente por LAG, as memórias ddr2 inicialmente tinham falores de latência maior do que os DDR1, e isso fez com que muita gente deixasse de atualizar-se, esperando que fosse feita uma certa correção, mas fora isso, a latência é uma informação desnecessárias para nós usuários comuns, a não ser que fizermos um overclock, ou montassemos um sistema profissional.

E não esqueçam, para placa mães que tem FSB HyperTransport ou tecnologia similar, trabalhar com números pares de memórias, faz com que você consiga um maior desempenho. Minhas memórias são de 2gb e eu tenho 2 delas instaladas, para desfrutar de 100% da potência. Vale lembrar que a memória é um dispositivo volátil, logo após o desligamento ou alguma falha, todos os dados são perdidos, por isso que existe a memória secundária.

Quanto a memória secundária, você toma como exemplo o

HD (HARD DISK, ou disco rígido) que armazena as informações para serem utilizadas posteriormente. Só é importante você saber o tipo de tecnologia utilizada por ele (IDE, SATA, SATAII) para que se possua um.

Agora vou falar do processador.

Meu processador é um

Athlon 64bit 2x Dual Core 5200+.

Só pela nomenclatura você pode saber de várias informações, como por exemplo, o 64bits, significa que o processador já trabalha com esse tipo de estrutura, “2x Dual Core” significa que são 2 núcleos, ou seja, equivalente a um Core 2 Duo da Intel e 5200+, significa que o computador podem atingir até 2.6ghz de velocidade para cada núcleo e por último, Athlon significa que o processador obedece a uma estrutura que a AMD criou.

Como seria a nomenclatura equivalente da Intel? Intel Core 2 Duo 2.6ghz. Por aí você já sabe que se é 2 núcleos pela definição da Intel, ele já trabalha a 64bits e tem um potencial de 2.6ghz por núcleo.

Outra informação importante sobre os processadores, são as sua especificações tais quais:

Memória Cache L1, L2...: Memória de alta velocidade, se uma informação está sendo MUITO utilizada, o processador carrega essa informação para o Cache do processador para que fique mais fácil a utilização. No caso do meu processador ele tem 128kb de L1 e 2mb de L2.

Na especificação do meu processador, diz que ele é WINDSOR, essa é uma nomenclatura para definir que tipo de núcleo é utilizado dentro do seu processador, e esse protótipo é definido pela fabrica.

Instruções multimídia: meu processador possui

MMX,

SSE,

SSE2,

SSE3,

3DNOW! Professional. E são instruções lógicas que facilitam certos tipos de trabalho, para quem entende de lógica matemática vai descobrir que o SSE é um sistema de ponto flutuante. O MMX é uma estrutura que trabalha em organizar o tratamento de dados, assim, ele consegue armazenar informações na memória, dizendo o TIPO de informação, quanto espaço ela ocupa e seu respectivo valor, SSE2 e SSE3 são evoluções da unidade computacional SSE, e o 3DNOW permite o processador fazer operações vetoriais e de gráficos facilmente possibilitando melhor desempenho nessas aplicações.

Veja uma foto explicativa do MMX:

Irei falar agora de dispositivos de entrada e de saída.

Dispositivos de entrada pode ser qualquer um que forneça informações ao computador, e dispositivos de saída pode ser qualquer um que o computador através dele consiga mostrar uma informação. Ex: Dispositivos de entrada: Mouse e Teclado. Dispositivos de saída: Monitor e Impressora.

Vou me prender principalmente ao dispositivos de saída gráfica “Monitor”, que utiliza uma peça só para ele, chamada “placa de vídeo”. A placa de vídeo é uma peça complexa, ela contem um processador só para ela, chamado de GPU(Graphical Process Unit), possui uma memória só para trabalhos gráficos, e possui uma arquitetura que possibilita fazer milhares de cálculos por segundo, muito mais rápido do que o processador do computador em casos específicos. As placas de vídeo hoje em dia, se definem em 2 fabricantes principais de GPU, NVIDIA e ATI. Minha placa de vídeo é uma GEFORCE 9600gt como disse acima, isso significa, que é de uma arquitetura nova, por definição ela é da 9000 Series da NVIDIA, que possui tecnologia de Pixel Shader 4.0, com support direto ao Directx 10.0, próprio do Windows Vista. Algumas tabelas da internet, dizem que minha placa de vídeo, chega a processar 52gb de dados por segundo, contendo apenas um buffer(memória) de 512mb para isso. O Processamento é tão alto, que existem alguns aplicativos que diz que a memória da placa de vídeo em vez de ser 512mb é 2gb(devido a comentário deixado no blog, devo explicar que essa dedução feita por tal programa ocorreu de uma formula interna de calculo de processamento, que não é oficial, mas que por dedução dele, achou que trabalharia nas mesmas proporções de uma placa de vídeo com buffer de 2gb). Segundo o fabricante, minha placa de vídeo é capaz de mandar 64 Pixeis por Clock, contendo um Clock de 650MHz para um núcleo de processamento e 1.650MHz para outro núcleo de processamento. seria mais ou menos (650+1.650)*64 Pixeis por segundo, muita coisa né? Mas isso é necessário para que os jogos mais atuais rodem com uma performance suficientemente boa para jogar.

Você pode utilizar uma ótima tabela comparativa neste

Link.

Huff, cansei, vejo vocês na próxima. :D